Qu’est-ce que le fichier WordPress robots.txt ? Comment créer un fichier robots.txt ? Pourquoi faut-il créer un fichier robots.txt ? L’optimisation du fichier robots.txt d’un site web permet-elle d’améliorer votre classement dans les moteurs de recherche ?

Nous aborderons toutes ces questions et bien d’autres encore dans cet article approfondi sur les fichiers robots.txt !

Avez-vous déjà voulu demander aux moteurs de recherche de ne pas explorer un fichier particulier ? Vouliez-vous empêcher les moteurs de recherche d’explorer un dossier particulier de votre site web ?

C’est là qu’intervient le fichier robots.txt. Il s’agit d’un simple fichier texte qui indique aux moteurs de recherche les endroits qu’ils doivent ou ne doivent pas explorer lors de l’indexation de votre site web.

La bonne nouvelle, c’est que vous n’avez besoin d’aucune expérience technique pour exploiter la puissance du fichier robots.txt.

Robots.txt est un simple fichier texte dont la création ne prend que quelques secondes. C’est également l’un des fichiers les plus faciles à abîmer. Il suffit qu’un seul caractère ne soit pas à sa place pour que tout le référencement de votre site soit perturbé et que les moteurs de recherche ne puissent pas accéder à votre site.

Le fichier robots.txt joue un rôle important dans l’optimisation du référencement d’un site web. Bien qu’il vous permette d’empêcher les moteurs de recherche d’accéder à différents fichiers et dossiers, ce n’est souvent pas la meilleure façon d’optimiser votre site.

Dans cet article, nous vous expliquons comment utiliser le fichier robots.txt pour optimiser votre site web. Nous vous montrerons également comment en créer un et nous vous présenterons quelques plugins que nous apprécions et qui peuvent faire le travail à votre place.

Qu’est-ce que le fichier WordPress Robots.txt ?

Robots.txt est un simple fichier texte qui indique aux robots des moteurs de recherche quelles pages de votre site doivent être explorées. Il indique également aux robots les pages qu’ils ne doivent pas explorer.

Avant d’entrer dans le vif du sujet, il est important de comprendre le fonctionnement d’un moteur de recherche.

Les moteurs de recherche ont trois fonctions principales : l’exploration, l’indexation et le classement.

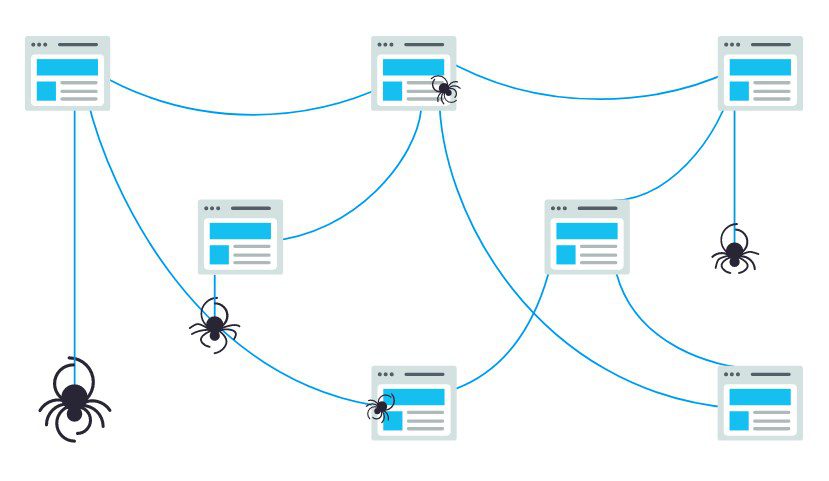

Les moteurs de recherche commencent par envoyer leurs robots d’indexation, également appelés “spiders” ou “bots”, sur le web. Ces robots sont des logiciels intelligents qui naviguent sur l’ensemble du web pour découvrir de nouveaux liens, pages et sites web. Ce processus d’exploration du web est appelé “crawling“.

Une fois que les robots ont découvert votre site web, vos pages sont organisées dans une structure de données utilisable. Ce processus s’appelle l’indexation.

Enfin, tout se résume au classement. Le moteur de recherche fournit à ses utilisateurs les informations les meilleures et les plus pertinentes en fonction de leurs requêtes.

À quoi ressemble le fichier WordPress Robots.txt ?

Supposons qu’un moteur de recherche s’apprête à visiter votre site. Avant de parcourir le site, il vérifiera d’abord si le fichier WordPress robots.txt contient des instructions.

Par exemple, disons que le robot du moteur de recherche est sur le point de parcourir notre site WPChanger et d’accéder à notre fichier robots.txt, accessible à partir de https://bloggerselite.com/robots.txt.

À ce propos, vous pouvez accéder au fichier robots.txt de n’importe quel site web en saisissant “/robots.txt” après le nom de domaine.

OK. Reprenons le cours des choses.

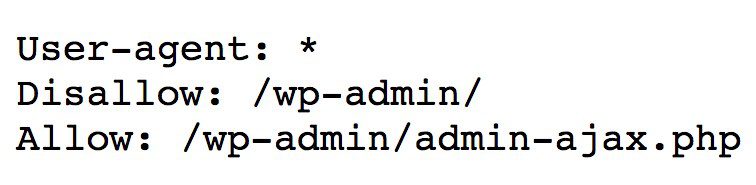

Ce qui précède est un format typique de ce à quoi ressemble un fichier robots.txt.

Et avant que vous ne pensiez que tout cela est trop technique, la bonne nouvelle est que c’est tout ce qu’il y a dans le fichier robots.txt. Enfin, presque.

Décortiquons chaque élément mentionné dans le fichier.

Le premier est User-agent : *.

L’astérisque qui suit User-agent indique que le fichier s’applique à tous les robots des moteurs de recherche qui visitent le site.

Chaque moteur de recherche a son propre user-agent qui parcourt le web. Par exemple, Google utilise Googlebot pour indexer le contenu de votre site web pour le moteur de recherche de Google.

Voici quelques-uns des autres user-agents utilisés par les moteurs de recherche les plus populaires,

- Google : Googlebot

- Googlebot News : Googlebot-News

- Googlebot Images : Googlebot-Image

- Googlebot Vidéo : Googlebot-Vidéo

- Bing : Bingbot

- Yahoo : Slurp Bot

- DuckDuckGo : DuckDuckBot

- Baidu : Baiduspider

- Yandex : YandexBot

- Exalead : ExaBot

- Alexa d’Amazon : ia_archiver

Il existe des centaines d’agents utilisateurs de ce type.

Vous pouvez définir des instructions personnalisées pour chaque user-agent. Par exemple, si vous souhaitez définir des instructions spécifiques pour Googlebot, la première ligne de votre fichier robots.txt sera la suivante,

User-agent : Googlebot

Vous pouvez assigner des directives à tous les user-agents en utilisant l’astérisque (*) à côté de User-agent.

Supposons que vous souhaitiez empêcher tous les robots, à l’exception de Googlebot, d’explorer votre site. Votre fichier robots.txt sera le suivant,

User-agent: * Disallow: / User-agent: Googlebot Allow: /

La barre oblique (/) qui suit Disallow indique au robot de n’indexer aucune page du site. Bien que vous ayez assigné une directive à tous les robots des moteurs de recherche, vous avez aussi explicitement autorisé le Googlebot à indexer votre site web en ajoutant “Allow : /.‘

De même, vous pouvez ajouter des directives pour autant d’agents utilisateurs que vous le souhaitez.

Pour récapituler, revenons à notre exemple de robots.txt Changer, c’est-à-dire,

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php

La directive a été définie pour que tous les robots des moteurs de recherche n’explorent rien sous le dossier “/wp-admin/“, mais suivent le fichier “admin-ajax.php” dans le même dossier.

C’est simple, non ?

Qu’est-ce qu’un budget de crawl ?

En ajoutant la barre oblique après Disallow, vous demandez au robot de ne visiter aucune page du site.

La question qui se pose alors est la suivante : pourquoi vouloir empêcher les robots d’explorer et d’indexer votre site ? Après tout, lorsque vous travaillez sur le référencement de votre site web, vous voulez que les moteurs de recherche parcourent votre site pour vous aider à vous classer.

C’est précisément la raison pour laquelle vous devriez envisager d’optimiser votre fichier robots.txt.

Avez-vous une idée du nombre de pages que contient votre site web ? Des pages proprement dites aux pages de test, en passant par les pages de contenu dupliqué et les pages de remerciement, entre autres. Nous supposons qu’il y en a beaucoup.

Lorsqu’un robot explore votre site web, il explore chaque page. Et si vous avez plusieurs pages, le robot du moteur de recherche mettra un certain temps à les parcourir toutes.

(Source : Seo Hacker)

Saviez-vous que cela peut avoir un impact négatif sur le classement de votre site web ?

Cela est dû au “budget d’exploration” du robot du moteur de recherche.

D’ACCORD. Qu’est-ce qu’un budget d’exploration ?

Le budget d’exploration est le nombre d’URL qu’un robot de recherche peut explorer au cours d’une session. Chaque site se voit attribuer un budget d’exploration spécifique. Vous devez vous assurer que ce budget est dépensé de la meilleure façon possible pour votre site.

Si votre site comporte plusieurs pages, vous voudrez certainement que le robot explore d’abord vos pages les plus importantes. Il est donc essentiel de le mentionner explicitement dans votre fichier robots.txt.

Consultez les ressources disponibles sur Google pour savoir ce que signifie le budget d’exploration pour Googlebot.

Comment créer un fichier Robots.txt dans WordPress?

Maintenant que nous avons expliqué ce qu’est un fichier robots.txt et son importance, créons-en un dans WordPress.

Il existe deux façons de créer un fichier robots.txt dans WordPress. La première consiste à utiliser un plugin WordPress et la seconde à télécharger manuellement le fichier dans le dossier racine de votre site web.

Méthode 1 : Créer un fichier WordPress Robots.txt à l’aide du plugin Yoast SEO

Pour vous aider à optimiser votre site web WordPress, vous pouvez utiliser des plugins SEO. La plupart de ces plugins sont livrés avec leur propre générateur de fichier robots.txt.

Dans cette section, nous allons en créer un à l’aide du plugin Yoast SEO. Grâce à ce plugin, vous pouvez facilement créer le fichier robots.txt à partir de votre tableau de bord WordPress.

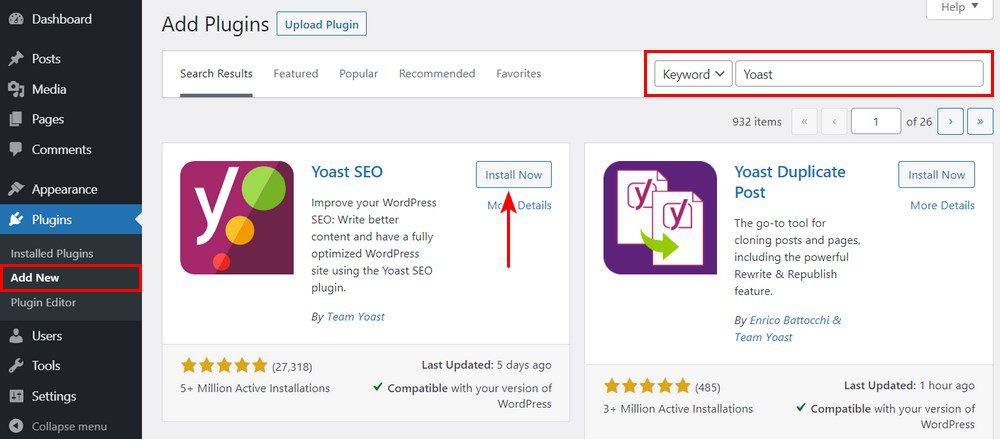

Étape 1. Installer le plugin

Rendez-vous dans la section Plugins > Ajouter un nouveau plugin. Ensuite, recherchez, installez et activez le plugin Yoast SEO si vous ne l’avez pas encore.

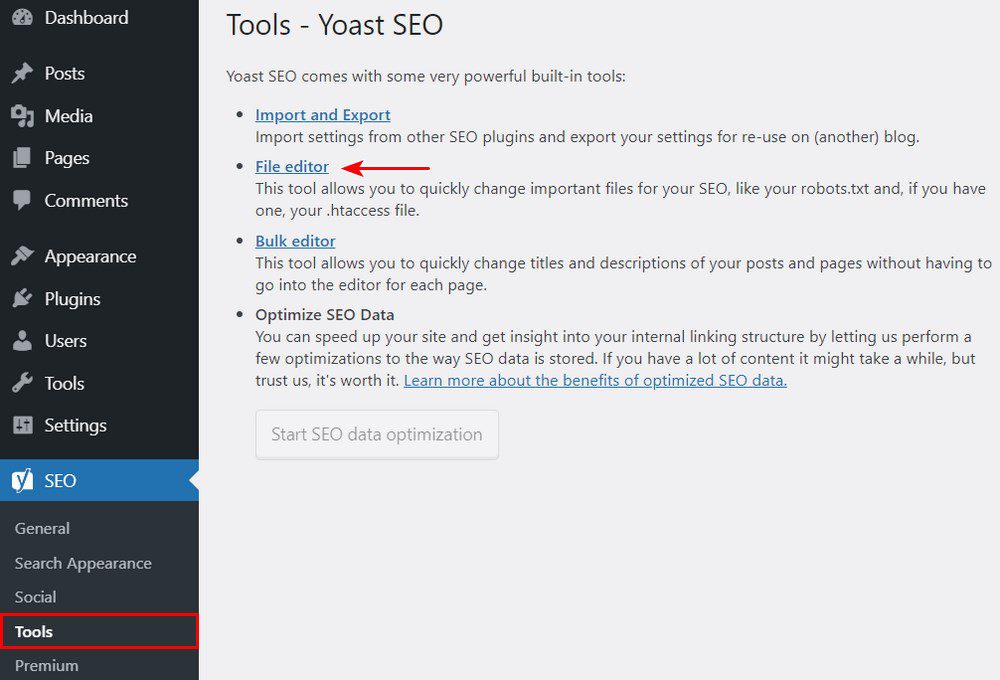

Etape 2. Créer le fichier robots.txt

Une fois le plugin activé, allez dans Yoast SEO > Outils et cliquez sur Éditeur de fichiers.

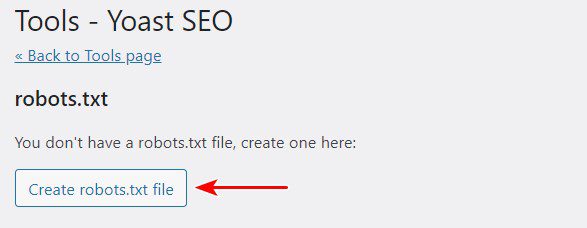

Puisque c’est la première fois que nous créons le fichier, cliquez sur Créer le fichier robots.txt.

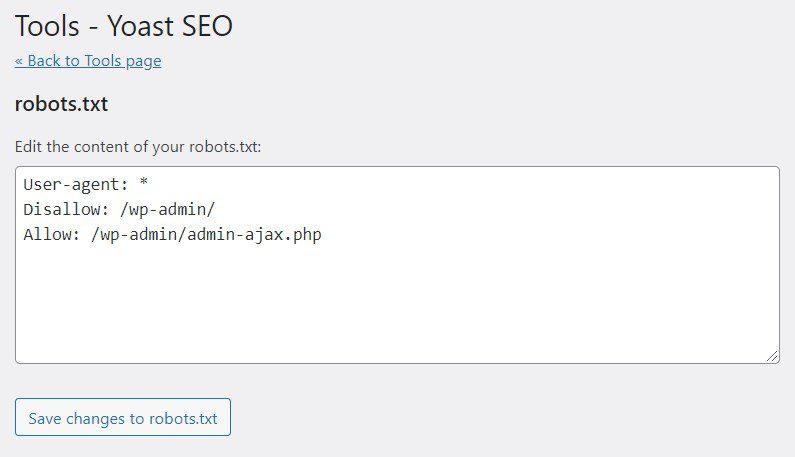

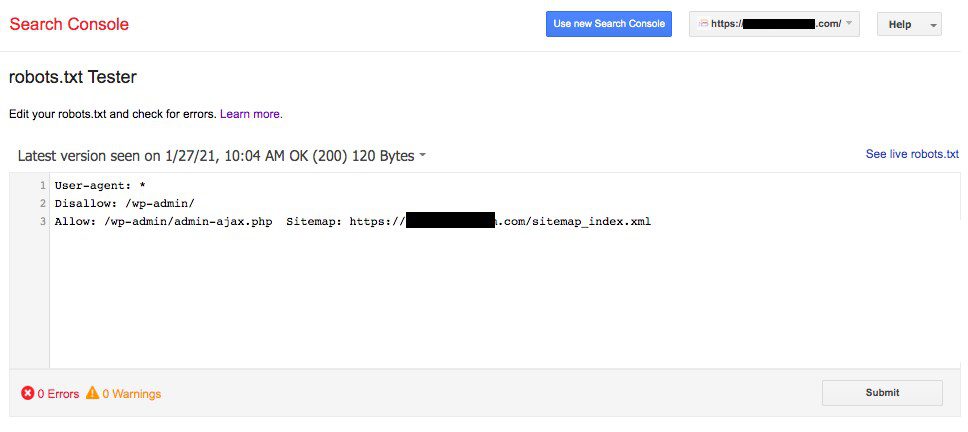

Vous remarquerez que le fichier a été créé avec quelques directives par défaut.

Par défaut, le générateur de fichier robots.txt de Yoast SEO ajoutera les directives suivantes,

User-agent : * Disallow : /wp-admin/ Allow : /wp-admin/admin-ajax.php

Vous pouvez ajouter d’autres directives au fichier robots.txt si vous le souhaitez. Lorsque vous avez terminé, cliquez sur Enregistrer les modifications apportées au fichier robots.txt.

Allez-y et tapez votre nom de domaine suivi de ‘/robots.txt’. Si les directives par défaut s’affichent dans le navigateur, comme le montre l’image ci-dessous, vous avez créé avec succès votre fichier robots.txt.

Nous vous recommandons également d’ajouter l’URL du sitemap dans votre fichier robots.txt.

Par exemple, si l’URL du sitemap de votre site web est https://yourdomain.com/sitemap.xml, pensez à inclure Sitemap : https://yourdomain.com/sitemap.xml dans votre fichier robots.txt.

Autre exemple : vous souhaitez créer une directive pour empêcher le robot d’explorer toutes les images de votre site web. Et disons que nous aimerions restreindre cette possibilité au seul robot Google.

Dans ce cas, notre fichier robots.txt sera le suivant,

User-agent : Googlebot Disallow : /uploads/ User-agent : * Autoriser : /uploads/

Et au cas où vous vous demanderiez comment trouver le nom du dossier de l’image, il vous suffit de faire un clic droit sur n’importe quelle image de votre site web, de sélectionner Ouvrir dans un nouvel onglet et de noter l’URL dans le navigateur. Et voilà !

Méthode 2 : Créer le fichier Robots.txt manuellement à l’aide du FTP

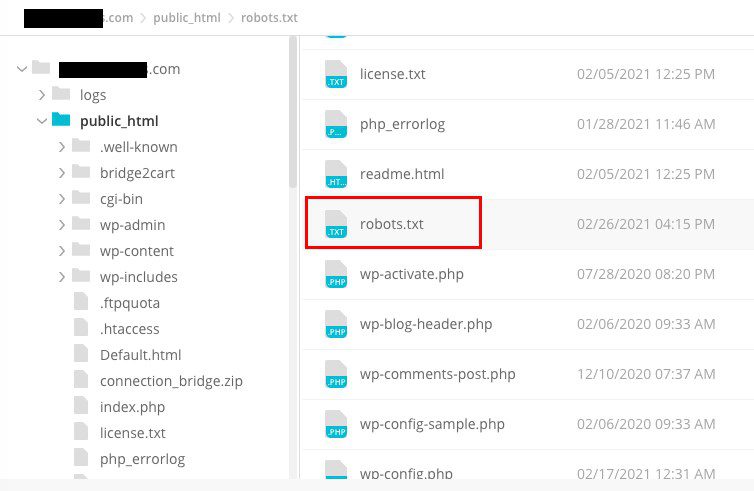

La méthode suivante consiste à créer un fichier robots.txt sur votre ordinateur local et à le télécharger dans le dossier racine de votre site web WordPress.

Vous aurez également besoin d’accéder à votre hébergement WordPress en utilisant un client FTP, tel que Filezilla. Les informations d’identification requises pour vous connecter seront disponibles dans votre panneau de contrôle d’hébergement si vous ne les avez pas déjà.

N’oubliez pas que le fichier robots.txt doit être téléchargé dans le dossier racine de votre site web. En d’autres termes, il ne doit se trouver dans aucun sous-répertoire.

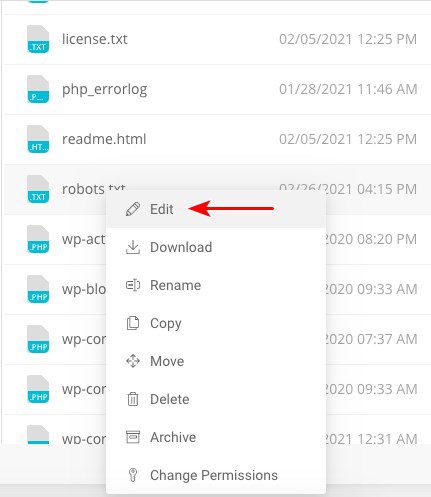

Ainsi, une fois que vous vous serez connecté à l’aide de votre client FTP, vous pourrez voir si le fichier robots.txt existe dans le dossier racine de votre site web.

Si le fichier existe, il vous suffit de cliquer avec le bouton droit de la souris sur le fichier et de sélectionner l’option “Modifier”.

Effectuez les modifications et cliquez sur Enregistrer.

Si le fichier n’existe pas, vous devez en créer un. Vous pouvez le créer en utilisant un simple éditeur de texte tel que Notepad et ajouter les directives au fichier.

Par exemple, incluez les directives suivantes,

User-agent : * Disallow : /wp-admin/ Allow : /wp-admin/admin-ajax.php

… et enregistrez le fichier sous robots.txt.

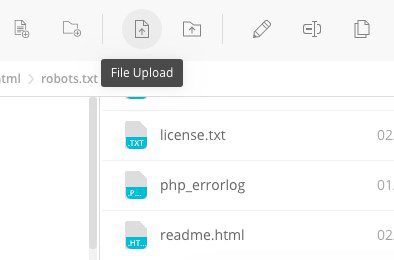

Maintenant, à l’aide de votre client FTP, cliquez sur “File Upload” et téléchargez le fichier dans le dossier racine du site web.

Pour vérifier si votre fichier a été téléchargé avec succès, tapez votre nom de domaine suivi de “/robots.txt.

Voilà comment télécharger manuellement le fichier robots.txt sur votre site Web WordPress !

Avantages et inconvénients du fichier Robots.txt

Avantages du fichier robots.txt

- Il permet d’optimiser les budgets d’exploration des moteurs de recherche en leur indiquant de ne pas perdre de temps sur les pages que vous ne souhaitez pas indexer. Cela permet de s’assurer que les moteurs de recherche explorent les pages qui sont les plus importantes pour vous.

- Il contribue à optimiser votre serveur web en bloquant les robots qui gaspillent les ressources.

- Il permet de masquer les pages de remerciement, les pages d’atterrissage, les pages de connexion, entre autres, qui n’ont pas besoin d’être indexées par les moteurs de recherche.

Les inconvénients du fichier robots.txt

- Vous savez maintenant comment accéder au fichier robots.txt pour n’importe quel site web. C’est très simple. Il suffit d’entrer le nom de domaine suivi de “/robots.txt. Cette méthode présente toutefois un certain nombre de risques. Le fichier robots.txt peut contenir des URL de certaines de vos pages internes que vous n’aimeriez pas voir indexées par les moteurs de recherche.

- Par exemple, il peut y avoir une page de connexion que vous ne souhaitez pas voir indexée. Toutefois, le fait de la mentionner dans le fichier robots.txt permet aux pirates d’y accéder. Il en va de même si vous essayez de cacher des données privées.

- Bien que la création du fichier robots.txt soit assez simple, si vous vous trompez ne serait-ce que d’un seul caractère, tous vos efforts en matière de référencement seront anéantis.

Où placer le fichier Robots.txt ?

Nous pensons que vous savez maintenant où le fichier robots.txt doit être ajouté.

Le fichier robots.txt doit toujours se trouver à la racine de votre site web. Si votre domaine est votredomaine.com, l’URL de votre fichier robots.txt sera https://yourdomain.com/robots.txt.

Outre l’inclusion de votre fichier robots.txt dans le répertoire racine, voici quelques bonnes pratiques à suivre,

- Il est essentiel de nommer votre fichier robots.txt

- Le nom est sensible à la casse. Il est essentiel de nommer votre fichier robots.txt. Le nom est sensible à la casse.

- Chaque directive doit être placée sur une nouvelle ligne

- Inclure le symbole “$” pour marquer la fin d’une URL.

- N’utilisez qu’une seule fois des agents utilisateurs individuels

- Utilisez des commentaires pour expliquer votre fichier robots.txt aux humains en commençant la ligne par un dièse (#).

Comment tester votre fichier Robots.txt ?

Maintenant que vous avez créé votre fichier robots.txt, il est temps de le tester à l’aide d’un outil de test de robots.txt.

L’outil que nous recommandons est celui qui se trouve dans la Search Console de Google.

Pour accéder à cet outil, cliquez sur Ouvrir le testeur de robots.txt.

Nous supposons que votre site web a été ajouté à Google Search Console. Si ce n’est pas le cas, cliquez sur “Ajouter une propriété maintenant” et suivez les étapes faciles à suivre pour inclure votre site web dans Google Search Console.

Une fois cette opération effectuée, votre site web apparaîtra dans le menu déroulant sous “Veuillez sélectionner un bien“.

Sélectionnez le site web et l’outil récupérera automatiquement le fichier robots.txt de votre site web et mettra en évidence les erreurs et les avertissements, le cas échéant.

Avez-vous besoin d’un fichier WordPress robots.txt pour votre site WordPress ?

Oui, vous avez besoin d’un fichier robots.txt sur votre site WordPress. Que vous ayez ou non un fichier robots.txt, les moteurs de recherche continueront à explorer et à indexer votre site web. Mais après avoir expliqué ce qu’est le fichier robots.txt, comment il fonctionne et le budget de crawl, pourquoi ne pas en inclure un ?

Le fichier robots.txt indique aux moteurs de recherche ce qu’ils doivent explorer et, plus important encore, ce qu’ils ne doivent pas faire.

L’une des principales raisons d’inclure le fichier robots.txt est la prise en compte des effets négatifs du budget d’exploration.

Comme indiqué précédemment, chaque site web dispose d’un budget d’exploration spécifique. Ce budget se résume au nombre de pages qu’un robot explore au cours d’une session. Si le robot ne parvient pas à explorer toutes les pages de votre site au cours de la session, il reviendra et reprendra l’exploration lors de la session suivante.

Cela ralentit le taux d’indexation de votre site web.

Une solution rapide consiste à empêcher les robots d’explorer les pages inutiles, les fichiers multimédias, les plugins, les dossiers de thèmes, entre autres, ce qui permet d’économiser votre quota d’exploration.

Autres Ressources :

- Comment créer un site WordPress portfolio – Guide détaillé

- Comment utiliser des images WebP dans WordPress : Le guide complet étape par étape

- Comment ajouter des Rich Snippets à WordPress – Guide du débutant

- 17 meilleurs thèmes WordPress SEO Friendly

- Comment configurer votre page d’accueil WordPress (3 façons très simples)

Conclusion

Lorsque nous travaillons sur le référencement de votre site web, nous accordons beaucoup d’importance à l’optimisation du contenu, à la recherche des bons mots-clés, au travail sur les backlinks, à la génération d’un sitemap.xml, entre autres facteurs. Un élément du référencement auquel certains webmasters accordent moins d’attention est le fichier robots.txt.

Le fichier robots.txt n’est peut-être pas d’une grande importance lorsque vous démarrez votre site web. Mais au fur et à mesure que votre site se développe et que le nombre de pages augmente, il est très avantageux de commencer à suivre les meilleures pratiques en ce qui concerne le fichier robots.txt.

Nous espérons que cet article vous a permis d’obtenir des informations utiles sur ce qu’est le fichier robots.txt et sur la manière d’en créer un sur votre site web. Quelles directives avez-vous définies dans votre fichier robots.txt ?

Articles connexes

- 21 meilleurs plugins WordPress Instagram pour 2024

- Comment ajouter un bouton dans WordPress (automatiquement et manuellement)

- 12 meilleurs plugins WooCommerce de Dropshipping en 2024

- Comment créer un site web d’abonnement incroyable en quelques minutes (aucun codage requis)

- 16 techniques SEO pour augmenter le trafic organique + les classements

- Recherche de mots clés pour le référencement : qu’est-ce que c’est et comment le faire

- Qu’est-ce qu’un plugin WordPress: Guide pour débutants

- Comment créer et gérer les rôles sur WordPress