Qu’est-ce que le fichier Robots.txt ?

Un fichier robots.txt est un ensemble d’instructions utilisées par les sites Web pour indiquer aux moteurs de recherche quelles pages doivent et ne doivent pas être explorées. Les fichiers Robots.txt guident l’accès des robots d’exploration, mais ne doivent pas être utilisés pour exclure des pages de l’index de Google.

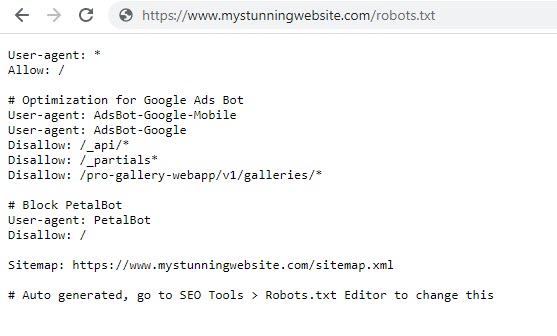

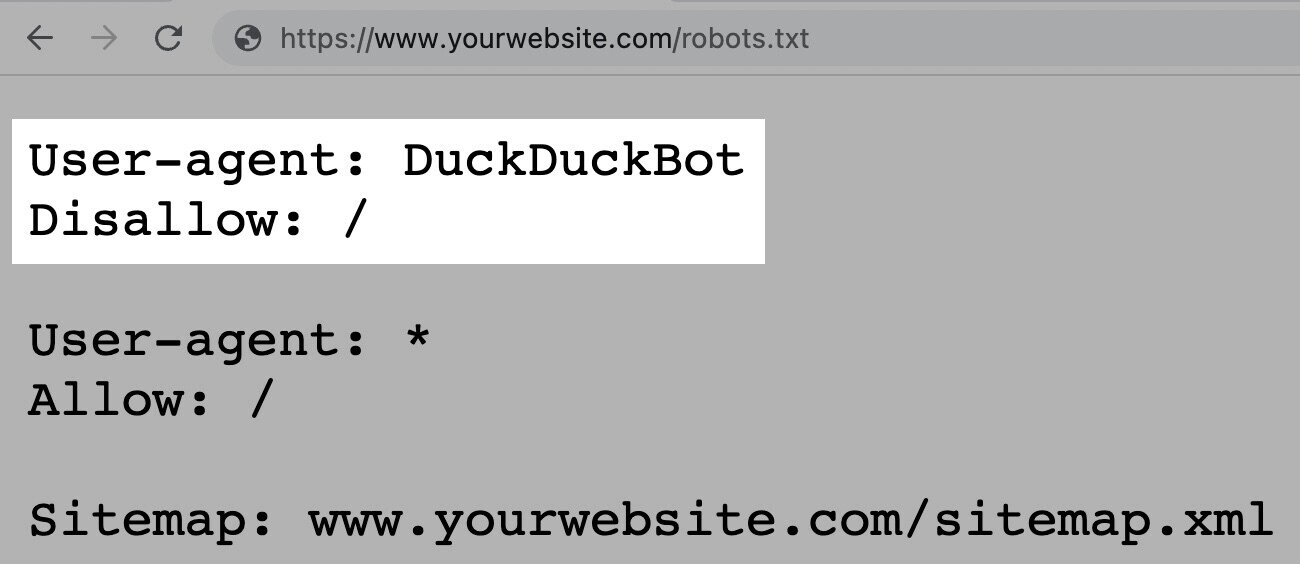

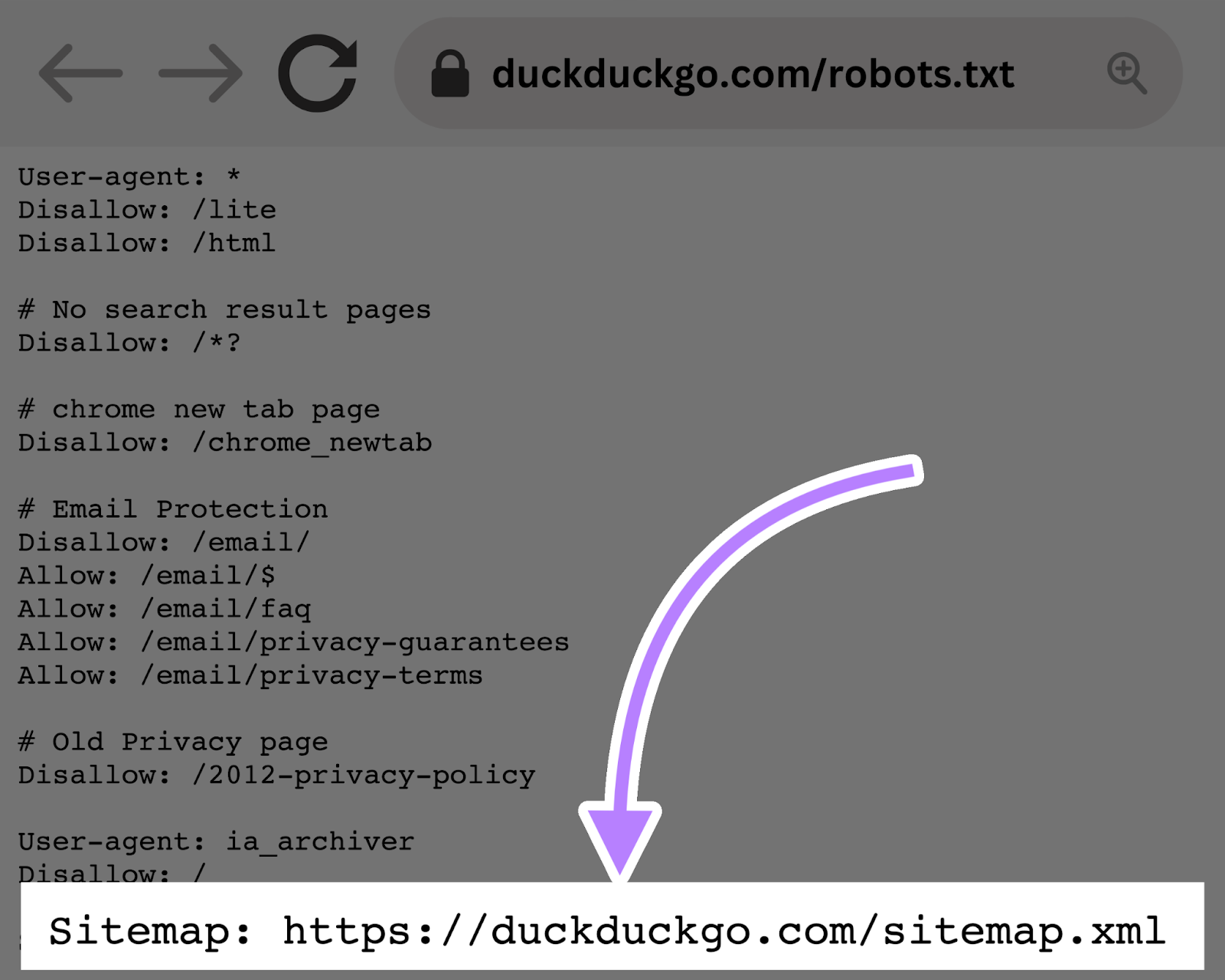

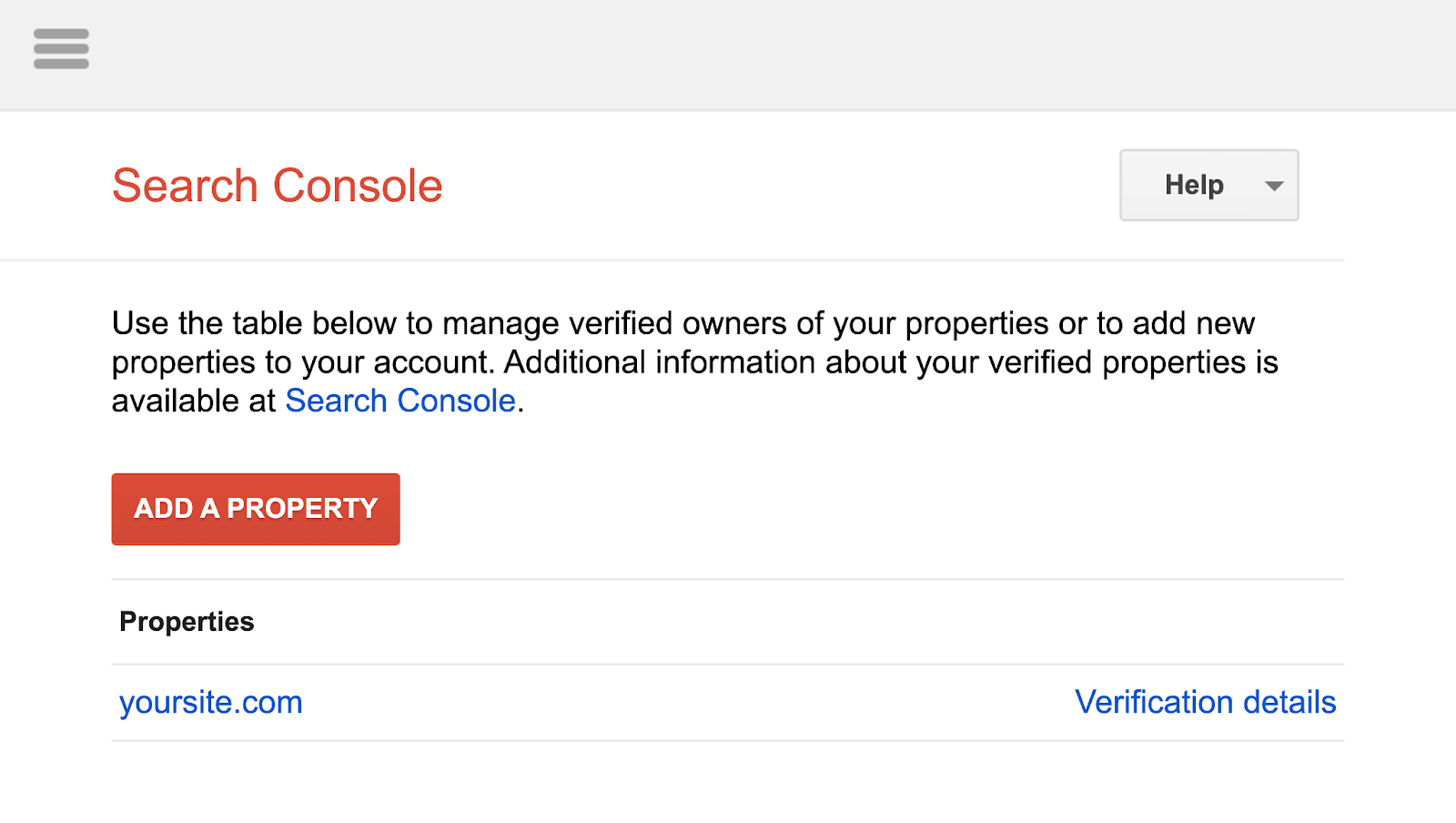

Un fichier robots.txt ressemble à ceci :

Les fichiers Robots.txt peuvent sembler compliqués, mais la syntaxe (langage informatique) est simple. Nous reviendrons sur ces détails plus tard.

Dans cet article, nous aborderons :

- Pourquoi les fichiers robots.txt sont importants

- Comment fonctionnent les fichiers robots.txt

- Comment créer un fichier robots.txt

- Bonnes pratiques pour les robots.txt

Table des matières

Pourquoi le fichier Robots.txt est-il important ?

Un fichier robots.txt aide à gérer les activités des robots d’exploration Web afin qu’ils ne surchargent pas votre site Web ou n’indexent pas les pages non destinées au public.

Vous trouverez ci-dessous quelques raisons d’utiliser un fichier robots.txt :

Optimiser le budget d’exploration

Le budget d’exploration fait référence au nombre de pages que Google explorera sur votre site dans un laps de temps donné.

Le nombre peut varier en fonction de la taille, de la santé et du nombre de backlinks de votre site .

Si le nombre de pages de votre site Web dépasse le budget d’exploration de votre site, vous pourriez avoir des pages non indexées sur votre site.

Les pages non indexées ne seront pas classées et, en fin de compte, vous perdrez du temps à créer des pages que les utilisateurs ne verront pas.

Le blocage des pages inutiles avec robots.txt permet à Googlebot (le robot d’exploration Web de Google) de consacrer plus de budget d’exploration aux pages importantes.

Remarque : selon Google , la plupart des propriétaires de sites Web n’ont pas à trop se soucier du budget d’exploration . Il s’agit principalement d’un problème pour les sites plus importants comportant des milliers d’URL.

Bloquer les pages en double et non publiques

Les robots d’exploration n’ont pas besoin de parcourir chaque page de votre site. Parce qu’ils n’ont pas tous été créés pour être servis dans les pages de résultats des moteurs de recherche (SERP).

Comme les sites de préparation, les pages de résultats de recherche internes, les pages en double ou les pages de connexion.

Certains systèmes de gestion de contenu gèrent ces pages internes pour vous.

WordPress, par exemple, interdit automatiquement la page de connexion /wp-admin/ pour tous les robots.

Robots.txt vous permet de bloquer ces pages des robots d’exploration.

Masquer les ressources

Parfois, vous souhaitez exclure des ressources telles que des fichiers PDF, des vidéos et des images des résultats de recherche.

Pour les garder privés ou pour que Google se concentre sur un contenu plus important.

Dans les deux cas, robots.txt les empêche d’être explorés (et donc indexés).

Comment fonctionne le fichier Robots.txt ?

Les fichiers Robots.txt indiquent aux robots des moteurs de recherche quelles URL ils peuvent explorer et, plus important encore, lesquelles ignorer.

Les moteurs de recherche ont deux objectifs principaux :

- Explorer le Web pour découvrir du contenu

- Indexer et fournir du contenu aux chercheurs à la recherche d’informations

En parcourant les pages Web, les robots des moteurs de recherche découvrent et suivent les liens. Ce processus les emmène du site A au site B puis au site C à travers des millions de liens, de pages et de sites Web.

Mais si un robot trouve un fichier robots.txt, il le lira avant de faire autre chose.

La syntaxe est simple.

Attribuez des règles en identifiant l’agent utilisateur (le robot du moteur de recherche), suivi des directives (les règles).

Vous pouvez également utiliser le caractère générique astérisque (*) pour attribuer des directives à chaque agent utilisateur, qui applique la règle à tous les robots.

Par exemple, l’instruction ci-dessous permet à tous les robots, à l’exception de DuckDuckGo, d’explorer votre site :

Remarque : Même si un fichier robots.txt fournit des instructions, il ne peut pas les appliquer. Considérez-le comme un code de conduite. Les bons robots (comme les robots des moteurs de recherche) suivront les règles, mais les mauvais robots (comme les robots spammeurs) les ignoreront.

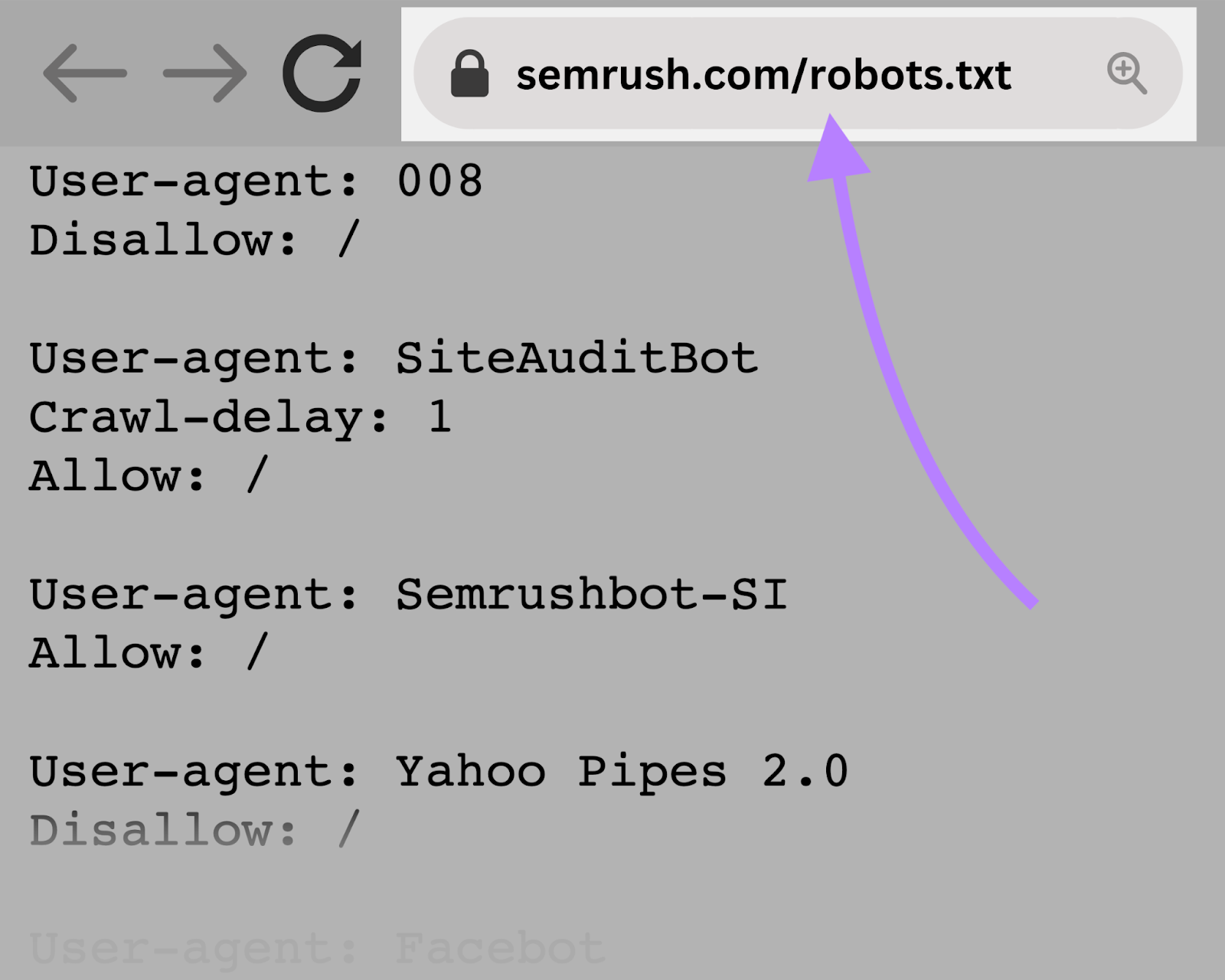

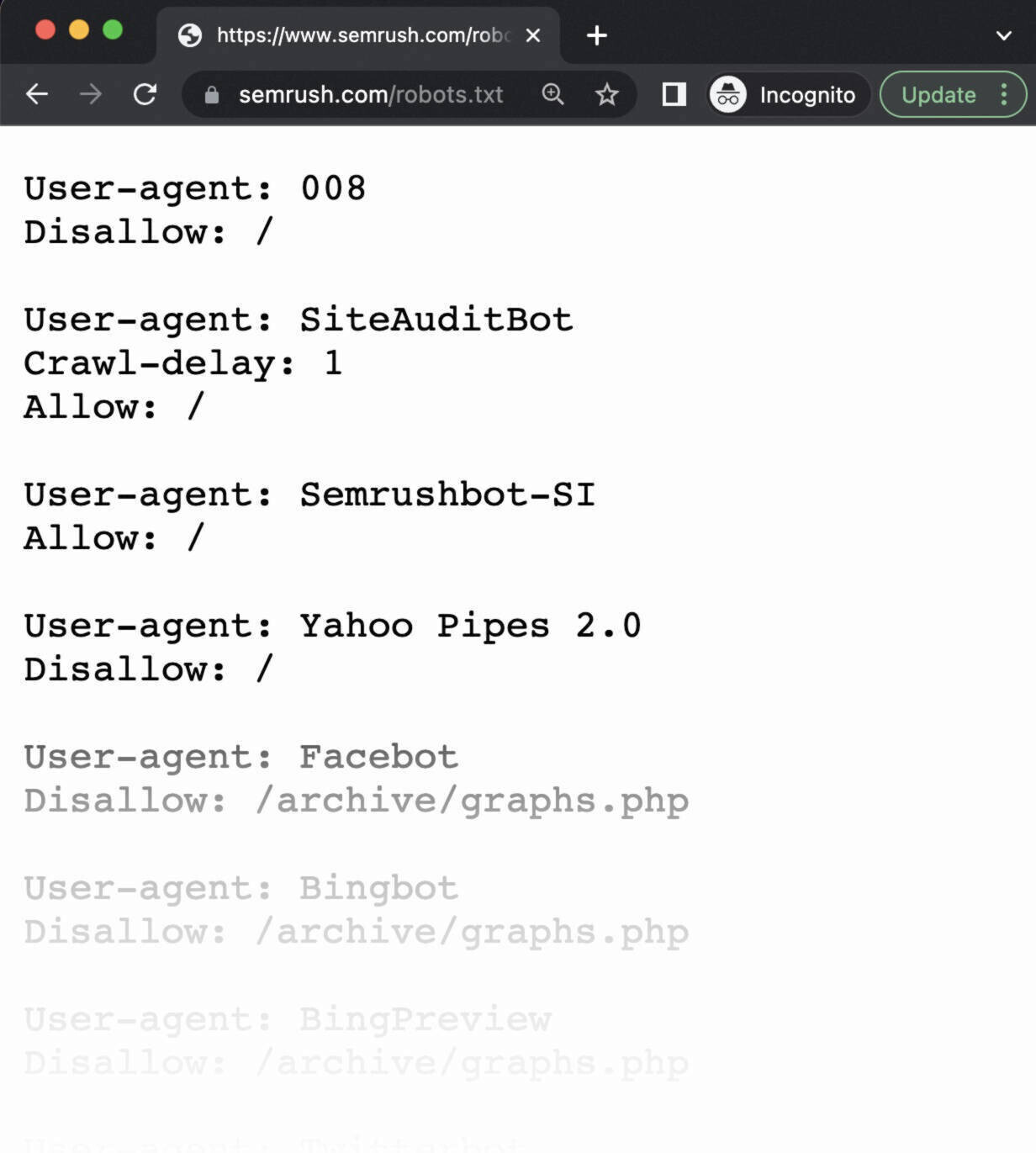

Les robots explorent le Web pour recueillir des informations pour nos outils d’optimisation de sites Web et plus encore.

les robots respectent les règles décrites dans votre fichier robots.txt.

Si vous empêchez aux robots d’explorer votre site Web, ils ne le feront pas.

Mais cela signifie également que vous ne pouvez pas utiliser certains outils à leur plein potentiel.

Par exemple, si vous avez empêché SiteAuditBot d’explorer votre site Web, vous ne pourrez pas auditer votre site avec l’outil d’audit de site de Semrush. Pour analyser et résoudre les problèmes techniques sur votre site.

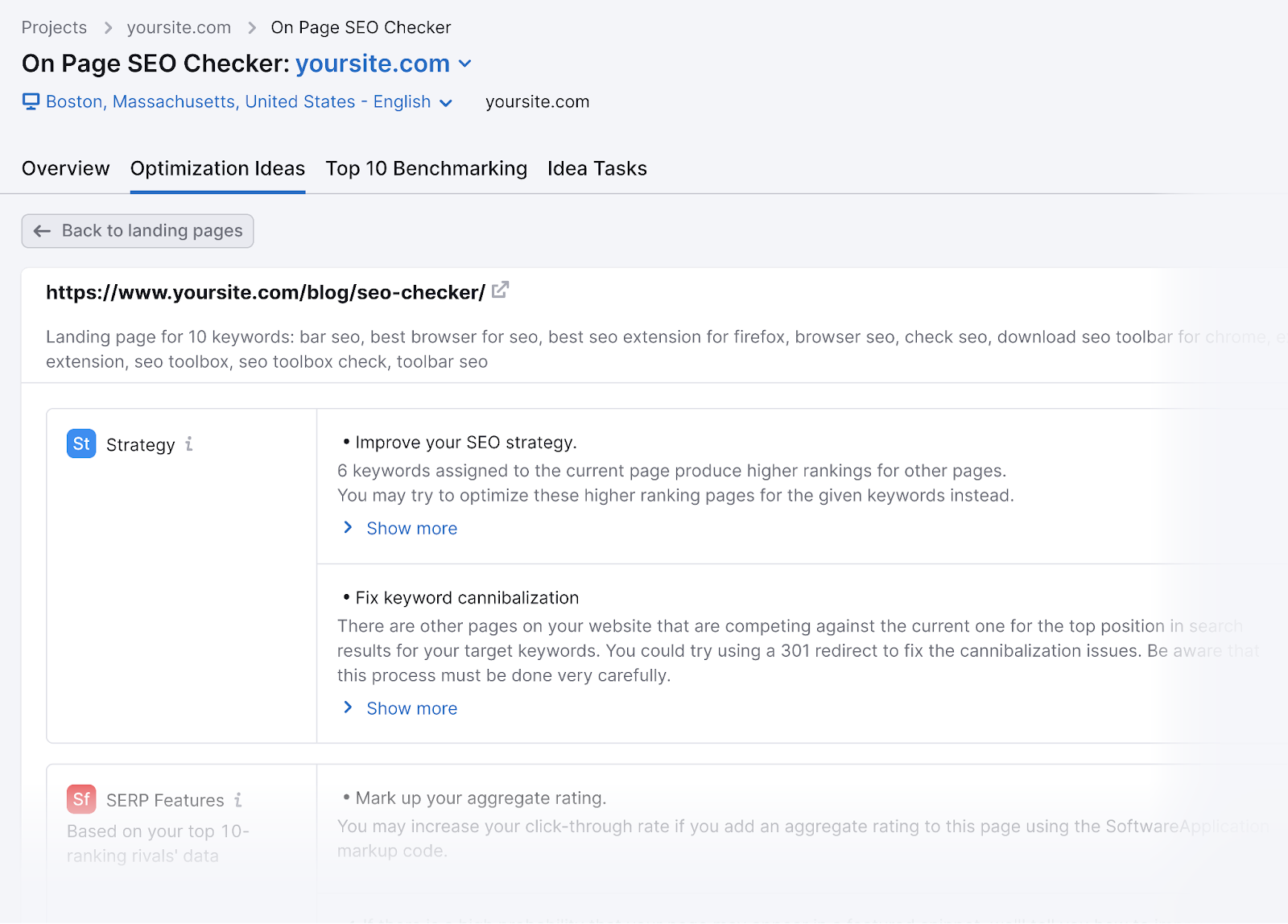

Si vous avez empêché SemrushBot-SI d’explorer votre site, vous ne pourrez pas utiliser efficacement l’ outil On Page SEO Checker .

Et vous perdriez la possibilité de générer des idées d’optimisation pour améliorer le classement de vos pages Web.

Comment trouver le fichier Robots.txt

Le fichier robots.txt est hébergé sur votre serveur, comme n’importe quel autre fichier de votre site Web.

Affichez le fichier robots.txt d’un site Web donné en tapant l’URL complète de la page d’accueil et en ajoutant « /robots.txt » à la fin.

Comme ceci : https://semrush.com/robots.txt .

Remarque : Un fichier robots.txt doit toujours résider au niveau du domaine racine. Pour www.example.com, le fichier robots.txt se trouve à l’adresse www.example.com/robots.txt. Placez-le ailleurs et les robots d’exploration pourraient supposer que vous n’en avez pas.

Avant d’apprendre à créer un fichier robots.txt, examinons leur syntaxe.

Syntaxe du fichier Robots.txt

Un fichier robots.txt est composé de :

- Un ou plusieurs blocs de « directives » (règles)

- Chacun avec un « agent utilisateur » spécifié (bot du moteur de recherche)

- Et une instruction « autoriser » ou « interdire »

Un simple bloc peut ressembler à ceci :

<code>User-agent: Googlebot<br>Disallow: /not-for-google<br>User-agent: DuckDuckBot<br>Disallow: /not-for-duckduckgo<br>Sitemap: https://www.yourwebsite.com/sitemap.xml</code>

La directive “User-agent” utilisateur-agent

La première ligne de chaque bloc de directives est l’agent utilisateur, qui identifie le robot.

Si vous souhaitez dire à Googlebot de ne pas explorer votre page d’administration WordPress, par exemple, votre directive commencera par :

<code>User-agent: Googlebot<br>Disallow: /wp-admin/</code>

Remarque : La plupart des moteurs de recherche disposent de plusieurs robots d’exploration . Ils utilisent différents robots pour l’indexation standard, les images, les vidéos, etc.

Lorsque plusieurs directives sont présentes, le bot peut choisir le bloc de directives disponible le plus spécifique.

Disons que vous disposez de trois ensembles de directives : une pour *, une pour Googlebot et une pour Googlebot-Image.

Si l’agent utilisateur Googlebot-News explore votre site, il suivra les directives de Googlebot.

En revanche, l’agent utilisateur Googlebot-Image suivra les directives plus spécifiques de Googlebot-Image.

La directive “Disallow” Interdire les robots.txt

La deuxième ligne d’une directive robots.txt est la ligne « Disallow ».

Vous pouvez avoir plusieurs directives d’interdiction qui spécifient les parties de votre site auxquelles le robot ne peut pas accéder.

Une ligne « Interdire » vide signifie que vous n’interdisez rien : un robot d’exploration peut accéder à toutes les sections de votre site.

Par exemple, si vous souhaitez autoriser tous les moteurs de recherche à explorer l’intégralité de votre site, votre bloc ressemblerait à ceci :

<code>User-agent: *<br>Allow: /</code>

Si vous souhaitez empêcher tous les moteurs de recherche d’explorer votre site, votre blocage ressemblerait à ceci :

<code>User-agent: *<br>Disallow: /</code>

Remarque : les directives telles que « Autoriser » et « Interdire » ne sont pas sensibles à la casse. Mais les valeurs contenues dans chaque directive le sont.

Par exemple, /photo/ n’est pas identique à /Photo/.

Pourtant, vous trouvez souvent les directives « Autoriser » et « Interdire » en majuscules pour rendre le fichier plus facile à lire pour les humains.

La directive “Allow” Autoriser

La directive « Autoriser » permet aux moteurs de recherche d’explorer un sous-répertoire ou une page spécifique, même dans un répertoire autrement interdit.

Par exemple, si vous souhaitez empêcher Googlebot d’accéder à tous les articles de votre blog sauf un, votre directive pourrait ressembler à ceci :

<code>User-agent: Googlebot<br>Disallow: /blog<br>Allow: /blog/example-post</code>

Remarque : Tous les moteurs de recherche ne reconnaissent pas cette commande. Mais Google et Bing soutiennent cette directive.

La directive “Sitemap”

La directive Sitemap indique aux moteurs de recherche, en particulier Bing, Yandex et Google, où trouver votre plan de site XML .

Les plans de site incluent généralement les pages que vous souhaitez que les moteurs de recherche explorent et indexent.

Cette directive se trouve en haut ou en bas d’un fichier robots.txt et ressemble à ceci :

L’ajout d’une directive Sitemap à votre fichier robots.txt est une alternative rapide. Mais vous pouvez (et devez) également soumettre votre plan de site XML à chaque moteur de recherche à l’aide de leurs outils pour les webmasters.

Les moteurs de recherche finiront par explorer votre site, mais la soumission d’un plan du site accélère le processus d’exploration.

Directive “crawl-delay”

La directive crawl-delay demande aux robots d’exploration de retarder leur vitesse d’exploration. Pour éviter de surcharger un serveur (c’est-à-dire de ralentir votre site Web).

Google ne prend plus en charge la directive crawl-delay. Si vous souhaitez définir votre vitesse d’exploration pour Googlebot, vous devrez le faire dans la Search Console .

Bing et Yandex , en revanche, prennent en charge la directive crawl-delay. Voici comment l’utiliser.

Supposons que vous souhaitiez qu’un robot attende 10 secondes après chaque action d’exploration. Réglez le délai sur 10, comme ceci :

<code>User-agent: *<br>Crawl-delay: 10</code>

Directive “Noindex”

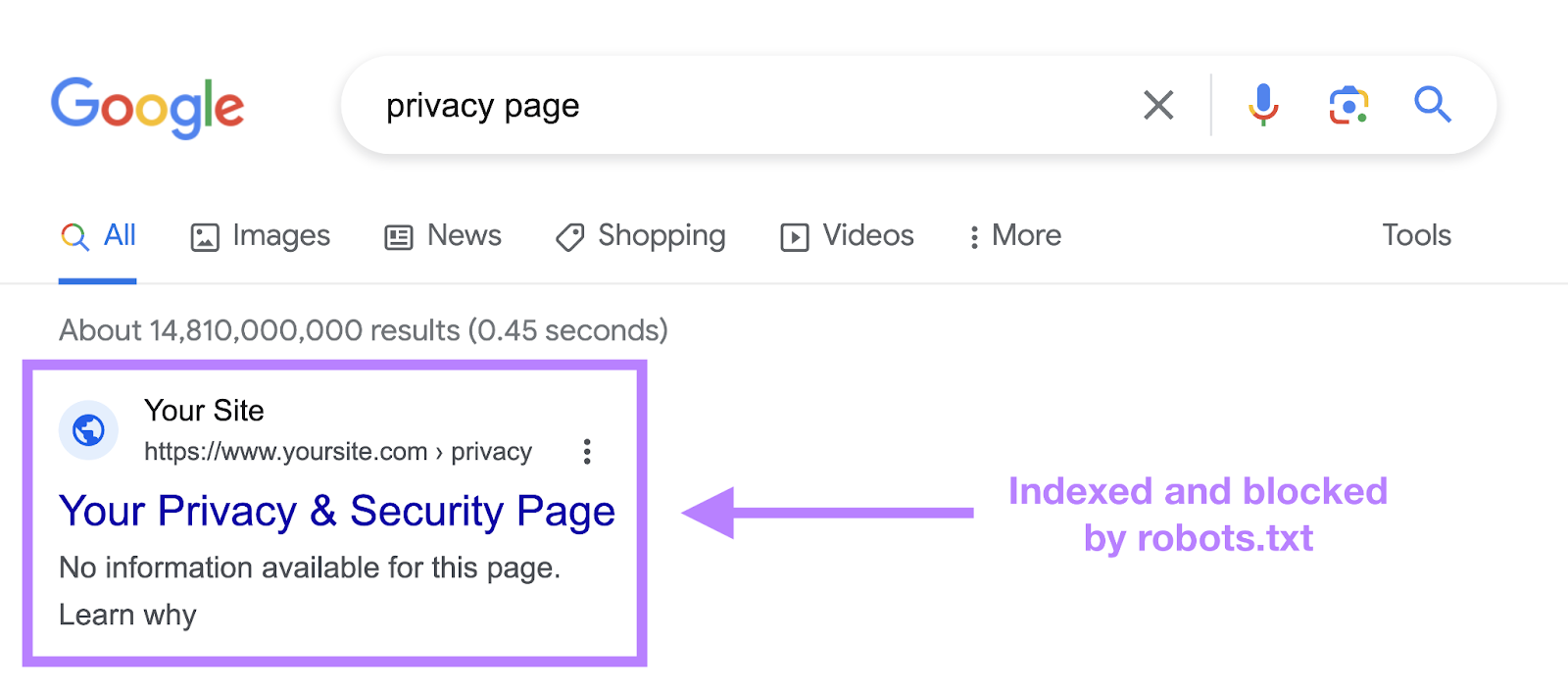

Le fichier robots.txt indique à un robot ce qu’il peut ou ne peut pas explorer, mais il ne peut pas indiquer à un moteur de recherche quelles URL ne pas indexer et afficher dans les résultats de recherche.

La page apparaîtra toujours dans les résultats de recherche, mais le bot ne saura pas ce qu’elle contient, donc votre page apparaîtra comme ceci :

Google n’a jamais officiellement soutenu cette directive, mais le 1er septembre 2019, Google a annoncé que cette directive n’était pas prise en charge .

Si vous souhaitez exclure de manière fiable une page ou un fichier de l’apparition des résultats de recherche, évitez complètement cette directive et utilisez une balise méta robots noindex .

Comment créer un fichier Robots.txt

Utilisez un outil générateur de robots.txt ou créez-en un vous-même.

Voici comment:

Créez un fichier et nommez-le Robots.txt

Commencez par ouvrir un document .txt dans un éditeur de texte ou un navigateur Web.

Remarque : N’utilisez pas de traitement de texte, car ils enregistrent souvent les fichiers dans un format propriétaire pouvant ajouter des caractères aléatoires.

Ensuite, nommez le document robots.txt.

Vous êtes maintenant prêt à commencer à taper des directives.

Ajouter des directives au fichier Robots.txt

Un fichier robots.txt se compose d’un ou plusieurs groupes de directives, et chaque groupe se compose de plusieurs lignes d’instructions.

Chaque groupe commence par un « agent utilisateur » et contient les informations suivantes :

- À qui s’applique le groupe (l’agent utilisateur)

- À quels répertoires (pages) ou fichiers l’agent peut accéder

- À quels répertoires (pages) ou fichiers l’agent ne peut pas accéder

- Un plan du site (facultatif) pour indiquer aux moteurs de recherche les pages et les fichiers que vous jugez importants

Les robots ignorent les lignes qui ne correspondent pas à ces directives.

Par exemple, disons que vous ne souhaitez pas que Google explore votre répertoire /clients/ car il est uniquement destiné à un usage interne.

Le premier groupe ressemblerait à ceci :

<code>User-agent: Googlebot<br>Disallow: /clients/</code>

Des instructions supplémentaires peuvent être ajoutées dans une ligne distincte ci-dessous, comme ceci :

<code>User-agent: Googlebot<br>Disallow: /clients/<br>Disallow: /not-for-google</code>

Une fois que vous avez terminé avec les instructions spécifiques de Google, appuyez deux fois sur Entrée pour créer un nouveau groupe de directives.

Faisons celui-ci pour tous les moteurs de recherche et empêchons-les d’explorer vos répertoires /archive/ et /support/ car ils sont destinés à un usage interne uniquement.

Cela ressemblerait à ceci :

<code>User-agent: Googlebot<br>Disallow: /clients/<br>Disallow: /not-for-google<br>User-agent: *<br>Disallow: /archive/<br>Disallow: /support/</code>

Une fois que vous avez terminé, ajoutez votre plan de site.

Votre fichier robots.txt terminé ressemblerait à ceci :

<code>User-agent: Googlebot<br>Disallow: /clients/<br>Disallow: /not-for-google<br>User-agent: *<br>Disallow: /archive/<br>Disallow: /support/<br>Sitemap: https://www.yourwebsite.com/sitemap.xml</code>

Enregistrez votre fichier robots.txt. N’oubliez pas qu’il doit s’appeler robots.txt.

Remarque : Les robots lisent de haut en bas et correspondent au premier groupe de règles le plus spécifique. Alors, démarrez d’abord votre fichier robots.txt avec des agents utilisateurs spécifiques, puis passez au caractère générique plus général (*) qui correspond à tous les robots.

Téléchargez le fichier Robots.txt

Après avoir enregistré le fichier robots.txt sur votre ordinateur, téléchargez-le sur votre site et rendez-le disponible pour que les moteurs de recherche puissent l’explorer.

Malheureusement, il n’existe pas d’outil universel pour cette étape.

Le téléchargement du fichier robots.txt dépend de la structure des fichiers et de l’hébergement Web de votre site.

Recherchez en ligne ou contactez votre fournisseur d’hébergement pour obtenir de l’aide sur le téléchargement de votre fichier robots.txt.

Par exemple, vous pouvez rechercher « télécharger le fichier robots.txt sur WordPress ».

Vous trouverez ci-dessous quelques articles expliquant comment télécharger votre fichier robots.txt sur les plateformes les plus populaires :

- Fichier Robots.txt dans WordPress

- Fichier Robots.txt dans Wix

- Fichier Robots.txt dans Joomla

- Fichier Robots.txt dans Shopify

- Fichier Robots.txt dans BigCommerce

Après le téléchargement, vérifiez si quelqu’un peut le voir et si Google peut le lire.

Voici comment.

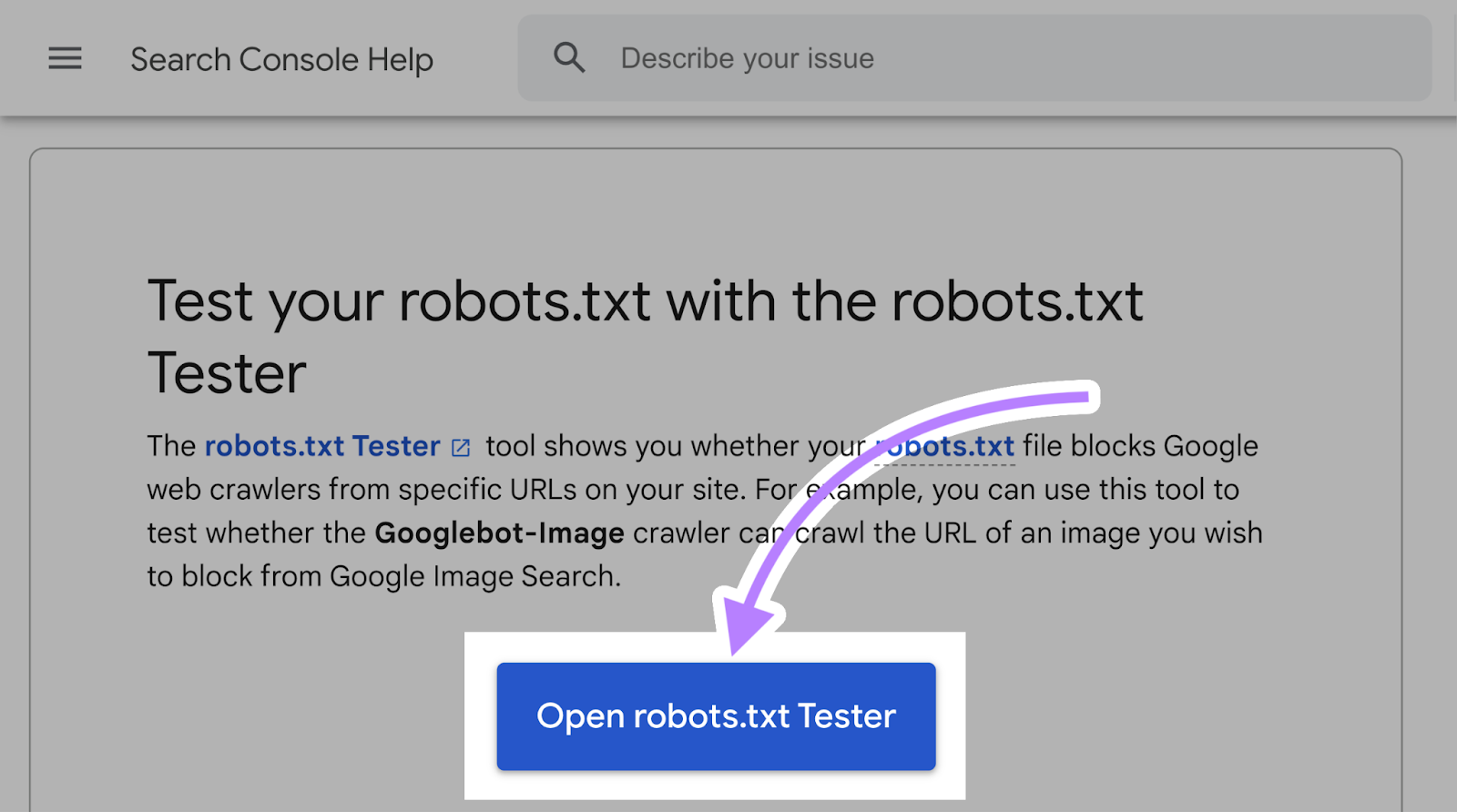

Testez votre fichier Robots.txt

Tout d’abord, testez si votre fichier robots.txt est accessible au public (c’est-à-dire s’il a été téléchargé correctement).

Ouvrez une fenêtre privée dans votre navigateur et recherchez votre fichier robots.txt.

Par exemple, https://semrush.com/robots.txt .

Si vous voyez votre fichier robots.txt avec le contenu que vous avez ajouté, vous êtes prêt à tester le balisage (code HTML).

Google propose deux options pour tester le balisage robots.txt :

- Le testeur robots.txt dans la Search Console

- Bibliothèque robots.txt open source de Google (avancée)

Étant donné que la deuxième option est destinée aux développeurs avancés, testons votre fichier robots.txt dans la Search Console.

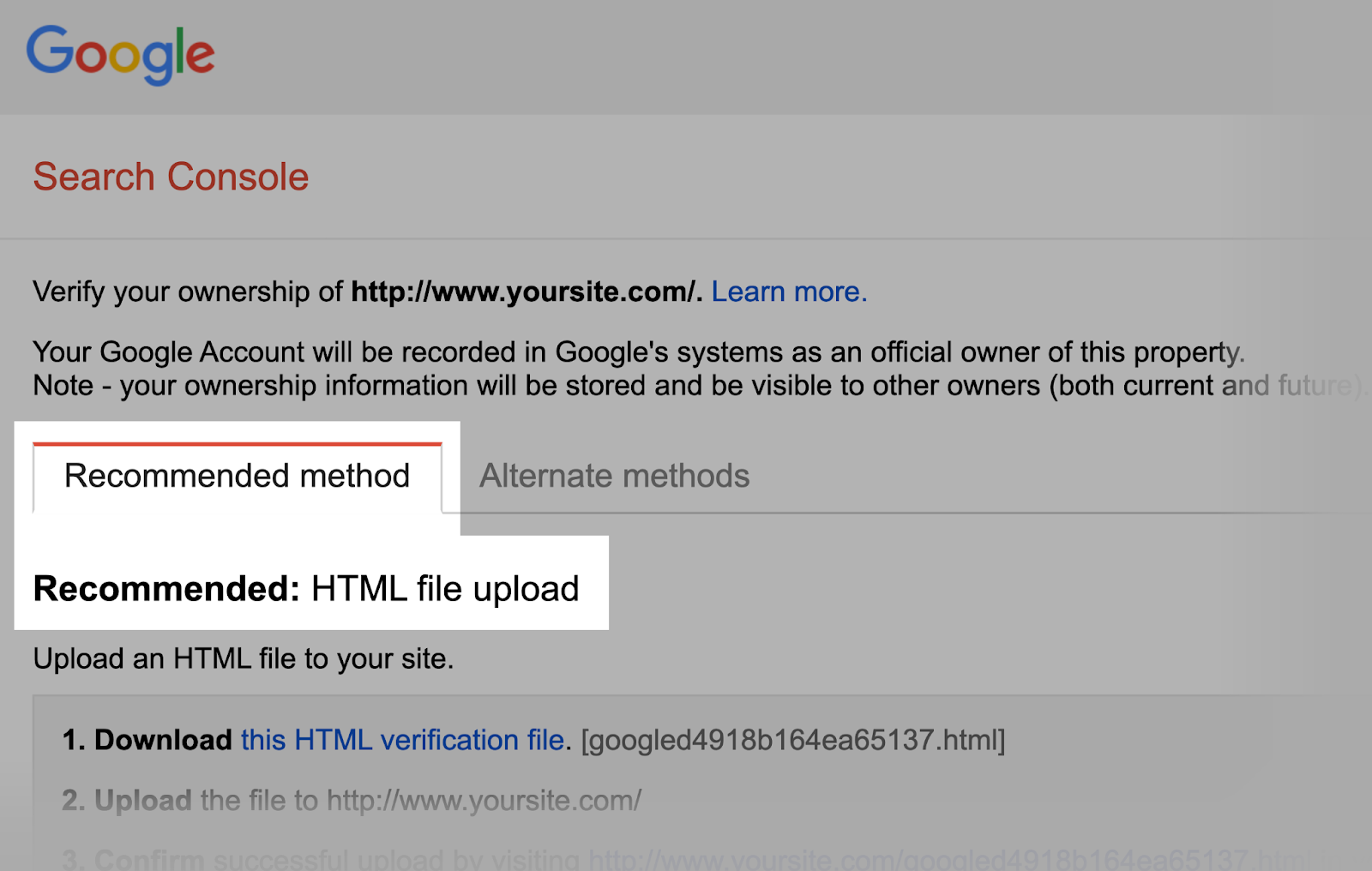

Remarque : Vous devez disposer d’un compte Search Console configuré pour tester votre fichier robots.txt.

Accédez au testeur robots.txt et cliquez sur « Ouvrir le testeur robots.txt ».

Si vous n’avez pas lié votre site Web à votre compte Google Search Console, vous devrez d’abord ajouter une propriété.

Vérifiez ensuite que vous êtes le véritable propriétaire du site.

Remarque : Google prévoit de fermer cet assistant de configuration. Ainsi, à l’avenir, vous devrez vérifier directement votre propriété dans la Search Console.

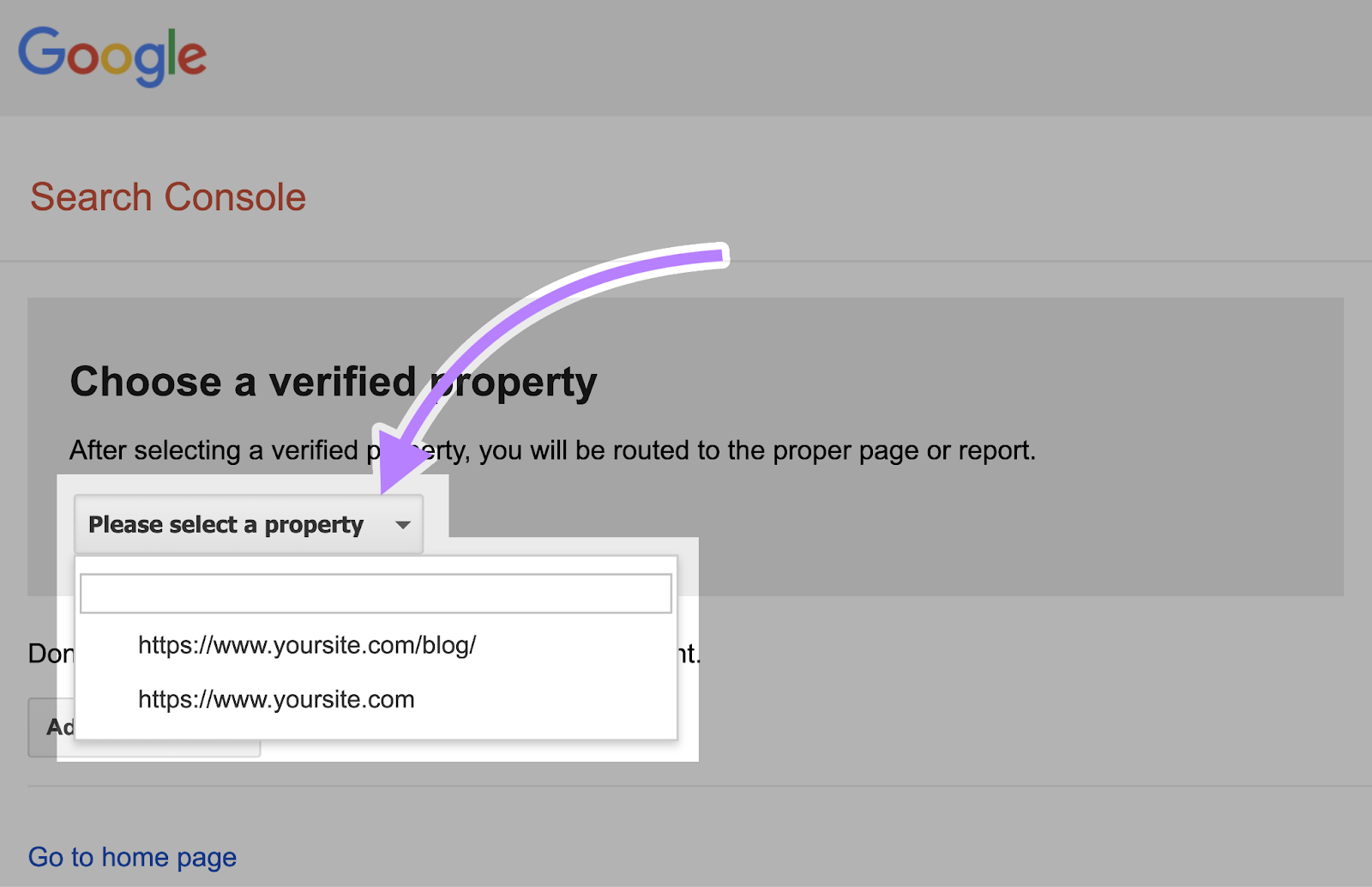

Si vous disposez de propriétés vérifiées existantes, sélectionnez-en une dans la liste déroulante de la page d’accueil du testeur.

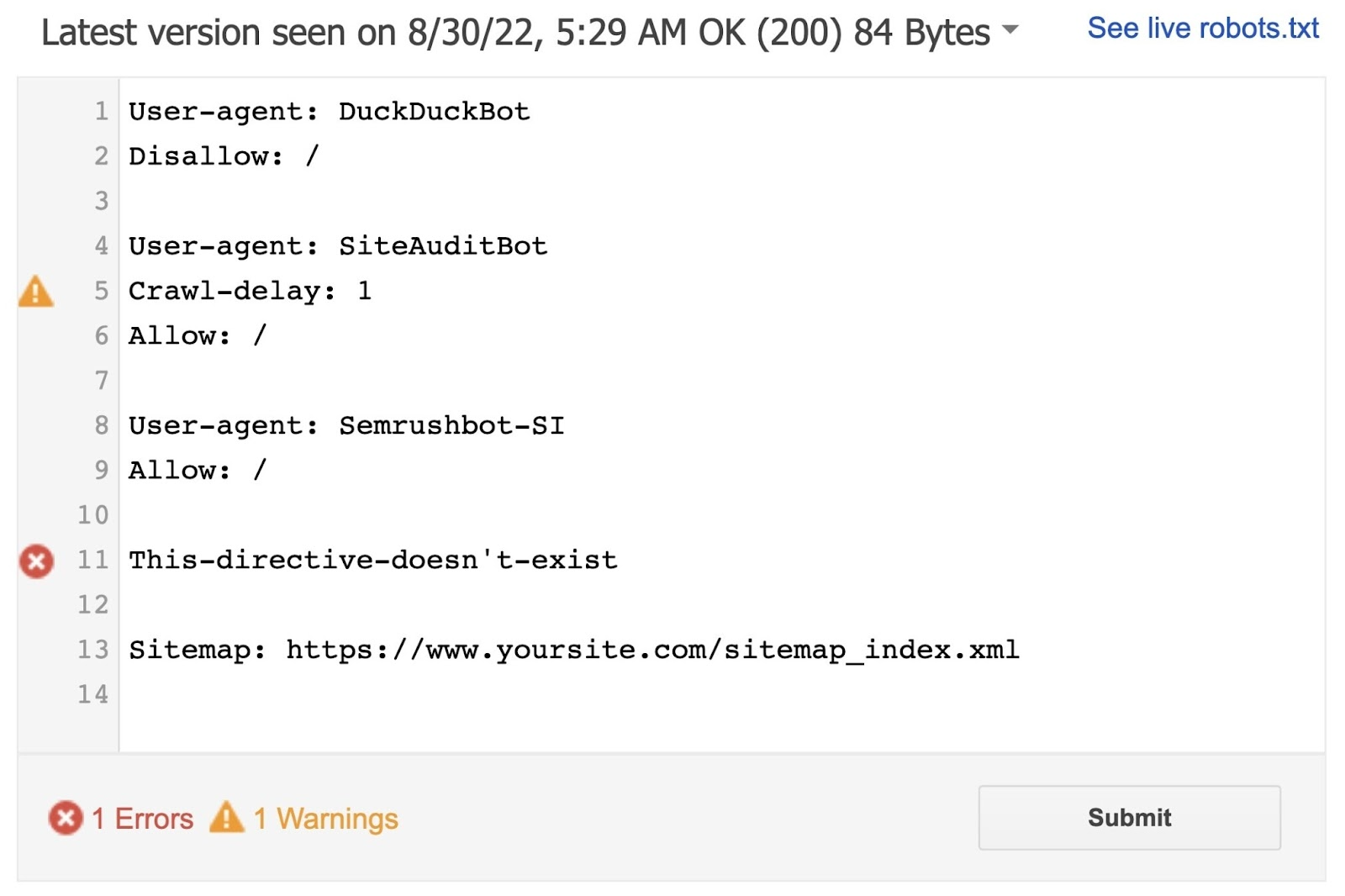

Le testeur identifiera les avertissements de syntaxe ou les erreurs logiques.

Et affichez le nombre total d’avertissements et d’erreurs sous l’éditeur.

Vous pouvez modifier les erreurs ou les avertissements directement sur la page et retester au fur et à mesure.

Les modifications apportées à la page ne sont pas enregistrées sur votre site. L’outil ne modifie pas le fichier réel sur votre site. Il teste uniquement par rapport à la copie hébergée dans l’outil.

Pour mettre en œuvre les modifications, copiez et collez la copie de test modifiée dans le fichier robots.txt de votre site.

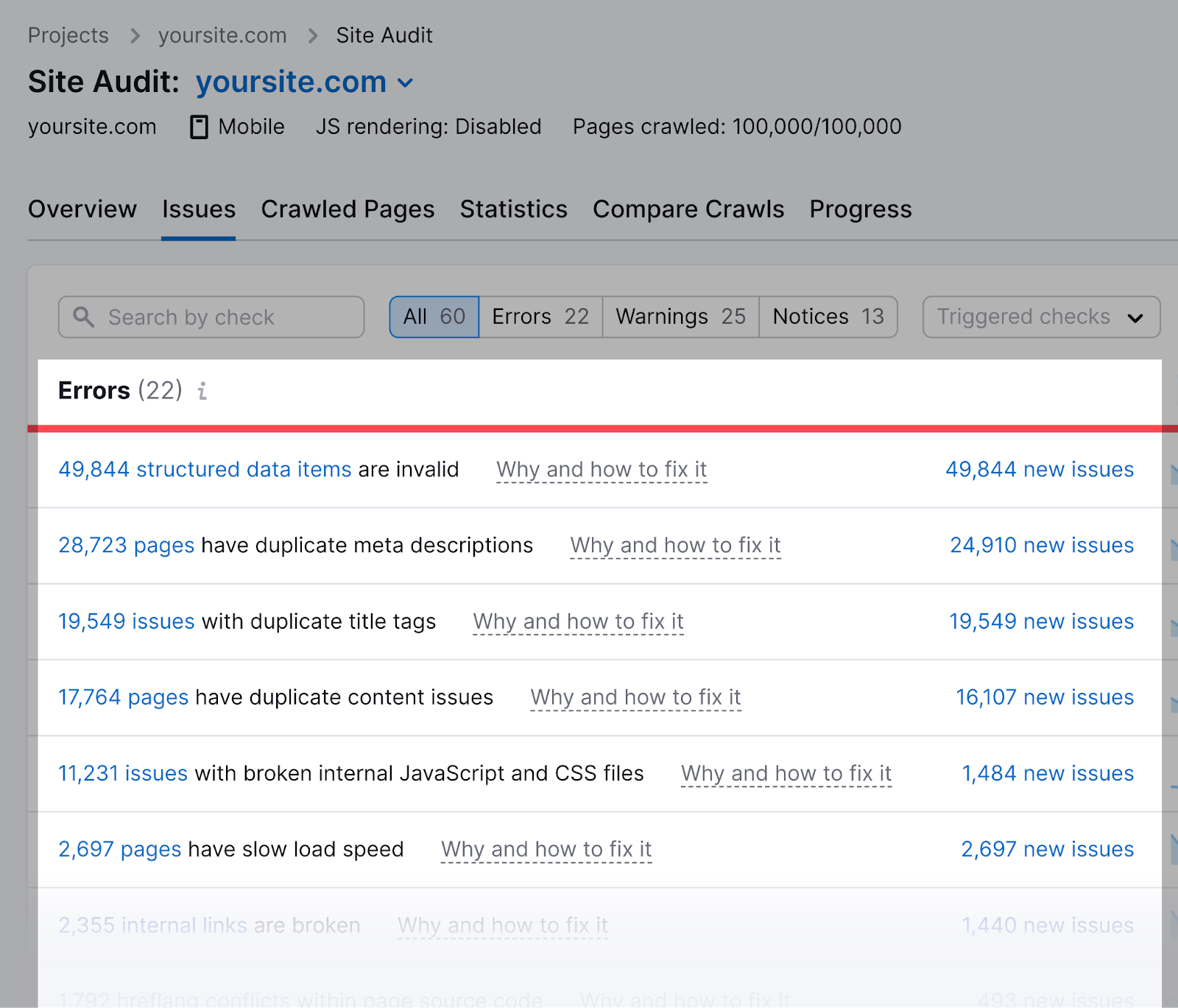

L’outil d’audit de site de Semrush peut vérifier les problèmes concernant votre fichier robots.txt.

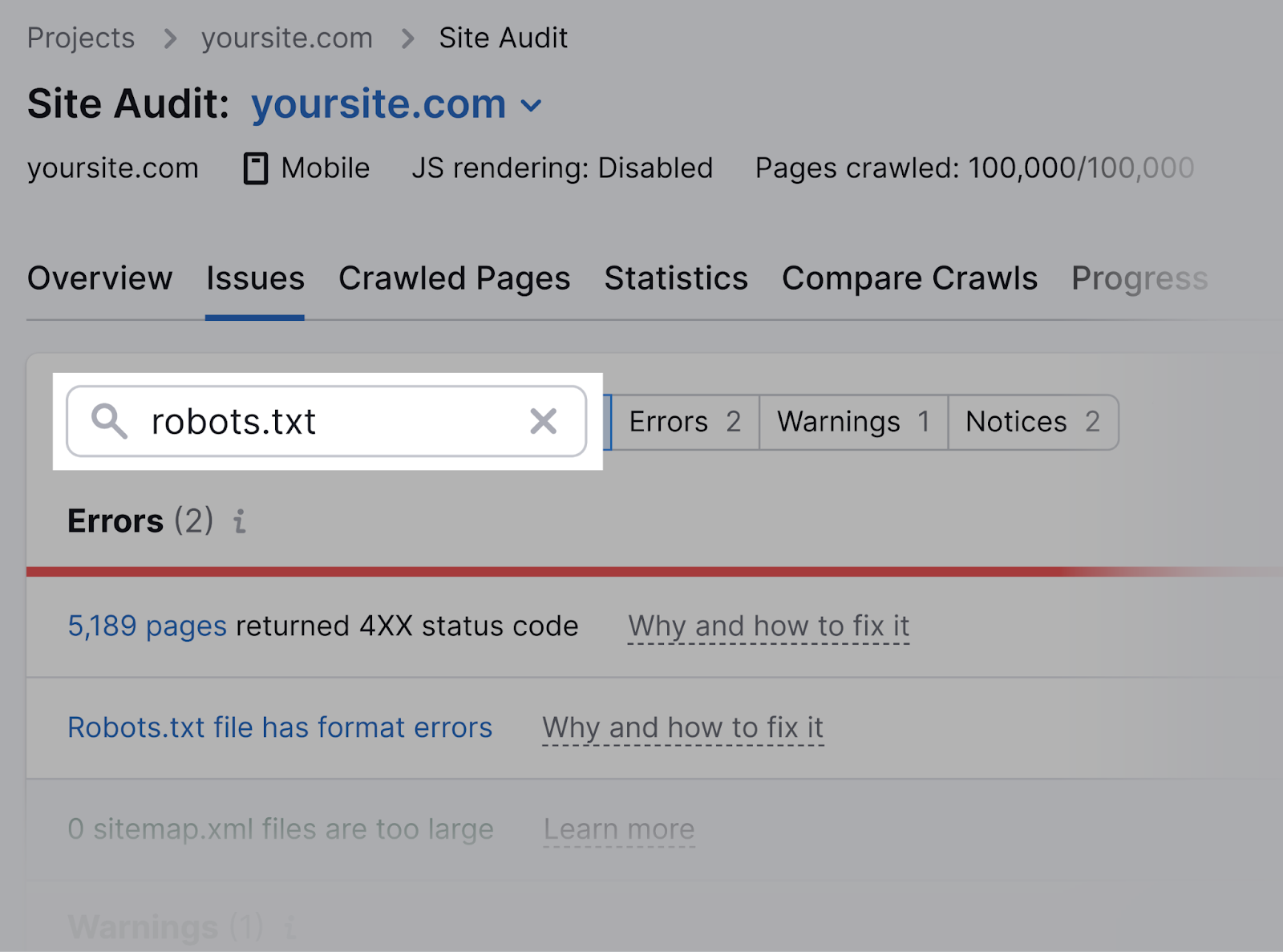

Tout d’abord, configurez un projet dans l’outil et auditez votre site Web.

Une fois terminé, accédez à l’onglet « Problèmes » et recherchez « robots.txt ».

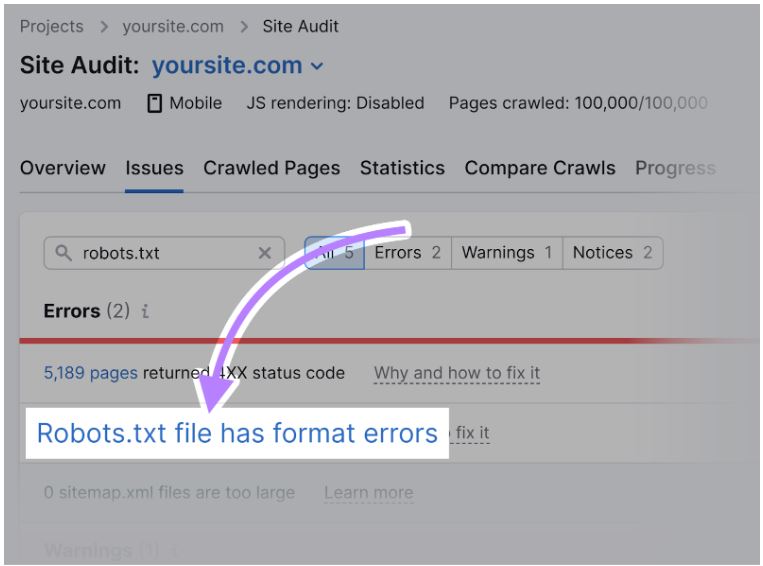

Cliquez sur le lien « Le fichier Robots.txt comporte des erreurs de format » s’il s’avère que votre fichier comporte des erreurs de format.

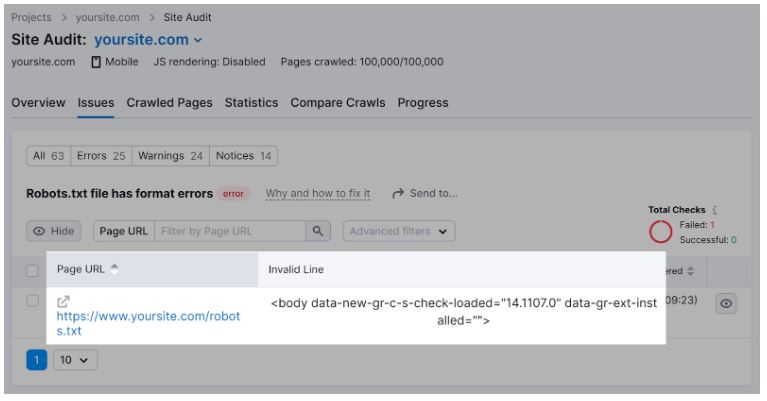

Vous verrez une liste de lignes invalides spécifiques.

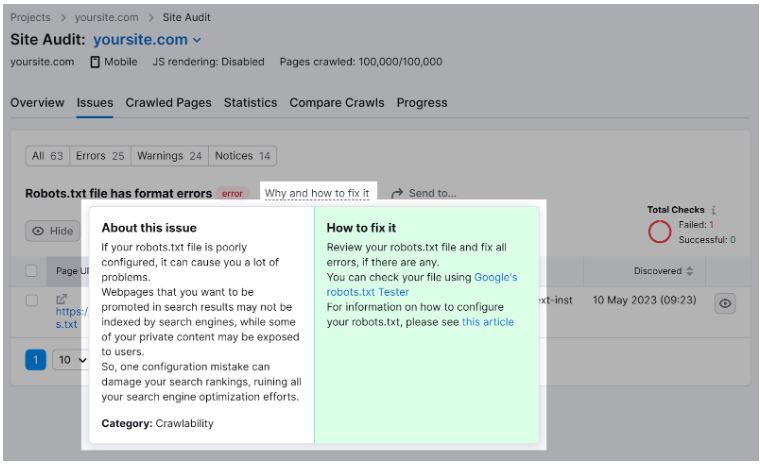

Vous pouvez cliquer sur « Pourquoi et comment le corriger » pour obtenir des instructions spécifiques sur la façon de corriger l’erreur.

Il est important de vérifier votre fichier robots.txt pour détecter tout problème, car même des erreurs mineures peuvent affecter négativement l’indexabilité de votre site.

Meilleures pratiques pour les robots.txt

Utiliser de nouvelles lignes pour chaque directive

Chaque directive doit se trouver sur une nouvelle ligne.

Sinon, les moteurs de recherche ne pourront pas les lire et vos instructions seront ignorées.

Incorrect:

<code>User-agent: * Disallow: /admin/<br>Disallow: /directory/</code>

Correct:

<code>User-agent: *<br>Disallow: /admin/<br>Disallow: /directory/</code>

Utiliser chaque agent utilisateur une fois

Cela ne dérange pas les robots si vous entrez plusieurs fois le même agent utilisateur.

Mais y faire référence une seule fois permet de garder les choses claires et simples. Et réduit le risque d’erreur humaine.

Déroutant:

<code>User-agent: Googlebot<br>Disallow: /example-page<br>User-agent: Googlebot<br>Disallow: /example-page-2</code>

Remarquez comment l’agent utilisateur de Googlebot est répertorié deux fois.

Clair:

<code>User-agent: Googlebot<br>Disallow: /example-page<br>Disallow: /example-page-2</code>

Dans le premier exemple, Google suivrait toujours les instructions et n’explorerait aucune des pages.

Mais écrire toutes les directives sous le même agent utilisateur est plus propre et vous aide à rester organisé.

Utilisez des caractères génériques pour clarifier les instructions

Vous pouvez utiliser des caractères génériques (*) pour appliquer une directive à tous les agents utilisateurs et faire correspondre les modèles d’URL.

Par exemple, pour empêcher les moteurs de recherche d’accéder aux URL avec des paramètres, vous pouvez techniquement les lister une par une.

Mais c’est inefficace. Vous pouvez simplifier vos itinéraires avec un caractère générique.

Inefficace:

<code>User-agent: *<br>Disallow: /shoes/vans?<br>Disallow: /shoes/nike?<br>Disallow: /shoes/adidas?</code>

Efficace:

<code>User-agent: *<br>Disallow: /shoes/*?</code>

L’exemple ci-dessus empêche tous les robots des moteurs de recherche d’explorer toutes les URL du sous-dossier /shoes/ avec un point d’interrogation.

Utilisez ‘$’ pour indiquer la fin d’une URL

L’ajout du « $ » indique la fin d’une URL.

Par exemple, si vous souhaitez empêcher les moteurs de recherche d’explorer tous les fichiers .jpg de votre site, vous pouvez les répertorier individuellement.

Mais ce serait inefficace.

Inefficace:

<code>User-agent: *<br>Disallow: /photo-a.jpg<br>Disallow: /photo-b.jpg<br>Disallow: /photo-c.jpg</code>

Au lieu de cela, ajoutez la fonctionnalité « $ », comme ceci :

Efficace:

<code>User-agent: *<br>Disallow: /*.jpg$</code>

Remarque : Dans cet exemple, /dog.jpg ne peut pas être exploré, mais /dog.jpg?p=32414 peut l’être car il ne se termine pas par « .jpg ».

L’expression « $ » est une fonctionnalité utile dans des circonstances spécifiques telles que celles ci-dessus. Mais cela peut aussi être dangereux.

Vous pouvez facilement débloquer des choses que vous ne vouliez pas, alors soyez prudent dans son application.

Utilisez le hachage (#) pour ajouter des commentaires

Les robots ignorent tout ce qui commence par un hachage (#).

Ainsi, les développeurs utilisent souvent un hachage pour ajouter un commentaire dans le fichier robots.txt. Cela permet de garder le fichier organisé et facile à lire.

Pour ajouter un commentaire, commencez la ligne par un dièse (#).

Comme ça:

<code>User-agent: *<br>#Landing Pages<br>Disallow: /landing/<br>Disallow: /lp/<br>#Files<br>Disallow: /files/<br>Disallow: /private-files/<br>#Websites<br>Allow: /website/*<br>Disallow: /website/search/*</code>

Les développeurs incluent parfois des messages amusants dans les fichiers robots.txt car ils savent que les utilisateurs les voient rarement.

Par exemple, le fichier robots.txt de YouTube indique : “Créé dans un futur lointain (l’an 2000) après le soulèvement robotique du milieu des années 90 qui a anéanti tous les humains.”

Et le fichier robots.txt de Nike indique « just crawl it » (un clin d’œil à son slogan « just do it ») et à son logo.

Utilisez des fichiers Robots.txt distincts pour différents sous-domaines

Les fichiers Robots.txt contrôlent le comportement d’exploration uniquement sur le sous-domaine dans lequel ils sont hébergés.

Pour contrôler l’exploration sur un sous-domaine différent, vous aurez besoin d’un fichier robots.txt distinct.

Ainsi, si votre site principal réside sur domain.com et que votre blog réside sur le sous-domaine blog.domain.com, vous aurez besoin de deux fichiers robots.txt.

Un pour le répertoire racine du domaine principal et l’autre pour le répertoire racine de votre blog.

Autres ressources

- Qu’est ce que le SEO ? Le guide ultime et complet

- Les meilleurs plugins WordPress de SEO en 2024 [Gratuits et Premiums]

Robots.Txt Définition importance : FAQ

C’est quoi un fichier robots.txt ?

Un fichier robots.txt indique aux robots d’exploration d’un moteur de recherche les URL auxquelles il peut accéder sur votre site

Comment trouver le robots.TXT d’un site ?

Le fichier robots. txt doit se trouver à la racine de l’hôte du site Web auquel il s’applique. Par exemple, afin de contrôler l’exploration de toutes les URL sous https://www.example.com/ , le fichier robots. txt doit se trouver à l’adresse https://www.example.com/robots.txt .

Comment modifier le fichier robots.txt ?

Ce fichier se trouve à la racine, tout comme le sitemap de votre site. Vous n’avez rien à faire pour le mettre en place, il est généré automatiquement à la création de votre site mais vous pouvez le modifier dans votre manager, dans Marketing > Référencement > Robots. txt.

Quel est le format TXT ?

Un fichier TXT est un fichier texte non formaté qui ne nécessite aucun programme spécial pour être créé et ouvert. Pour ouvrir un fichier TXT, la plupart des systèmes d’exploitation proposent des programmes de traitement de texte comme « Bloc-Notes » sous Windows ou « TextEdit » sous macOS.

Quels sont sont les instructions constituant un fichiers robots.txt ?

Les fichiers robots.txt utilisent les instructions ou commandes suivantes : User-agent : les user-agents sont les robots des moteurs de recherche, par exemple Googlebot pour Google ou Bingbot pour Bing. Disallow : disallow est l’instruction qui interdit aux user-agents l’accès à une url ou à un dossier.

Articles connexes

- Fonctionnalités des SERP : Guide détaillé

- Elementor Loop Builder : Qu’est-ce que c’est et comment l’utiliser ?

- Taux de rebond : Définition et Bon taux de rebond [Le guide ultime]

- Comment jouer une vidéo au survol dans Elementor

- Elementor vs Divi vs SeedProd – Quel est le meilleur en 2024 ?

- Elementor Cloud vs Divi Cloud : Lequel choisir en 2024 ? [Comparaison Ultime]

- Comment ajouter une bordure dégradée à la galerie d’images dans Elementor

- Comment créer et afficher un popup par balise de publication dans WordPress

![Robots.txt : Définition, importance pour l'optimisation SEO [Guide ultime]](https://bloggerselite.com/wp-content/uploads/2024/04/robot-txt.jpg)